Par Navidh Mansoor, directeur de rédaction Metaobs.média

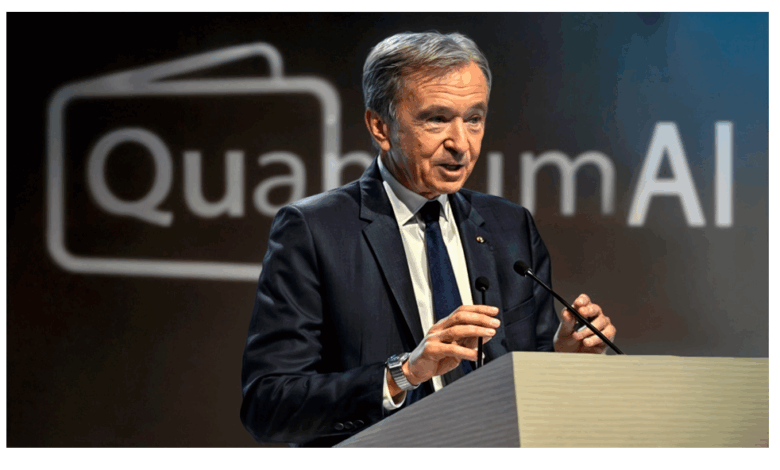

Une arnaque en ligne utilisant une vidéo deepfake de Bernard Arnault, révélée le 3 octobre 2025

L’homme d’affaires est présenté comme promouvant une plateforme d’investissement à rendements faramineux via une publicité sponsorisée sur YouTube. Cette vidéo, très réaliste, montre une version modifiée de Bernard Arnault s’exprimant devant un pupitre, affirmant pouvoir gagner 1 000 euros par jour, mais il n’a jamais prononcé ces mots.

« Bonjour, je suis Bernard Arnault. Je vous offre la possibilité de gagner 1.000 euros par jour, c’est une occasion unique de changer votre vie pour le mieux ».

L’original de l’intervention provient d’une conférence de 2017 au sommet VivaTech, où aucune mention de ce dispositif n’était faite. Le deepfake vise à diriger les internautes vers une fausse page de média, similaire à un article du Monde, ou vers une fausse page gouvernementale, avec des témoignages inventés et des visuels falsifiés. Ces arnaques, qui utilisent des figures publiques pour créer un sentiment de légitimité, sont de plus en plus sophistiquées, rendant leur détection difficile.

La vidéo deepfake de Bernard Arnault promeut une plateforme d’investissement fictive via une publicité YouTube, utilisant une voix et des lèvres synchronisées à partir d’une vidéo originale de 2017. Le contenu de la vidéo, qui prétend que l’homme d’affaires offre une opportunité unique de gagner 1 000 euros par jour, est entièrement faux et ces liens mènent à des pages falsifiées, copiant le style de médias comme Le Monde ou info.gouv.fr, avec des témoignages inventés et des logos de sécurité utilisés sans autorisation.

La qualité des deepfakes est en constante amélioration

Les arnaques de ce type sont fréquentes et de qualité augmentant le risque de manipulation. Les outils d’IA génératives sont rendus de plus en plus accessibles aux plus grand nombre et avec peu de qualifications requises. Les tentatives d’escroquerie déjà sophistiqués dans le cyberspace prennent une tournure autrement plus difficile à détecter tant le réalisme est impressionnant au premier coup d’œil.

Ces arnaques suivent une mécanique classique : appât médiatique, capture de données, appel téléphonique par un « conseiller », puis extraction d’argent via des promesses de gains simulés.

Elles imbriquent une combinaison d’éléments capable de toucher plusieurs sens: vidéo transformé par l’intelligence artificielle, son et voix ultra réaliste, liens vers une plateforme web propre et authentique dans sa forme et réception d’un appel téléphonique si les coordonnées ont été saisies.

Les plateformes les plus consultées tels Youtube ou Meta offrent un terrain de jeu gigantesque et idéal à cette escroquerie organisée, ce qui doit pousser à la vigilance personnelle de tout internaute.

En avril dernier, un annonceur nommé Relief Eligibility Center a diffusé en avril et mai, sur les plateformes de Meta, une publicité contenant une vidéo manipulée de Donald Trump. Celle-ci le montrait promettant aux Américains des « chèques de relance à la consommation ».

La séquence provenait en réalité d’un discours prononcé par l’ancien président à la Maison-Blanche début avril et les propos tenus dans la vidéo ne correspondent pas à la transcription officielle de cet événement.

Les dernières études confirment une hausse spectaculaire de la fraude en ligne : aux Etats-Unis, un nombre croissant d’Américains adultes sont victimes d’arnaques sur internet ou d’usurpations d’identité.

L’agence américaine chargée de la protection des consommateurs a indiqué que le nombre de plaintes déposées par des personnes âgées ayant perdu au moins 5000 dollars avait été multiplié par cinq depuis 2020.

Des solutions semblent désormais sérieusement à l’étude pour démasquer les deepfakes.

La solution interne d’OpenAI contre les « Cameos » non consentis

Les Cameos sont des “personnages réutilisables” créés à partir de l’audio et de la vidéo fournis par les utilisateurs eux-mêmes. Ces derniers doivent accepter explicitement la création de leur propre deepfake, puis définir qui peut y accéder : eux seuls, des personnes approuvées, leurs amis ou tout le monde.

Jusqu’à présent, le contrôle s’arrêtait là : si ton Cameo était activé en accès public, ton image numérique pouvait être utilisée pour n’importe quel type de contenu.

Le modèle vidéo d’intelligence artificielle de seconde génération d’OpenAI, Sora 2, suscite déjà la controverse, moins d’une semaine après la présentation très attendue de cet outil et de son application associée. La polémique découle de la puissance impressionnante de Sora 2, capable de générer presque n’importe quelle scène avec un niveau de précision saisissant. Peu après son lancement, la plateforme conçue comme un réseau social centré sur la vidéo, à la manière de TikTok ou Reels a été inondée de contenus problématiques : deepfakes de célébrités, vidéos politiques sensibles et personnages sous licence.

Face aux inquiétudes des utilisateurs, OpenAI a reconnu les risques liés à l’accès libre à l’image numérique d’une personne et a annoncé de nouvelles restrictions de contenu pour sa fonction Cameos. L’entreprise semble prendre en considération les inquiétudes et précise désormais les règles à suivre pour mieux protéger l’usage des avatars et éviter les détournements.