Par Frederik Dembak, directeur en Chef adjoint Investissement

Des “miracles” technologiques qui frappent l’imaginaire

On a vu passer l’annonce : un stéthoscope connecté, propulsé par une IA, capable de détecter en quinze secondes plusieurs pathologies cardiaques et pulmonaires. À Londres, certains hôpitaux l’expérimentent déjà. En Inde, l’État du Tamil Nadu teste une IA pour accélérer le diagnostic des maladies chroniques dans ses dispensaires.

Ces innovations font rêver : plus de rapidité, moins de coûts, accès élargi aux soins. On parle parfois de « médecine augmentée ».

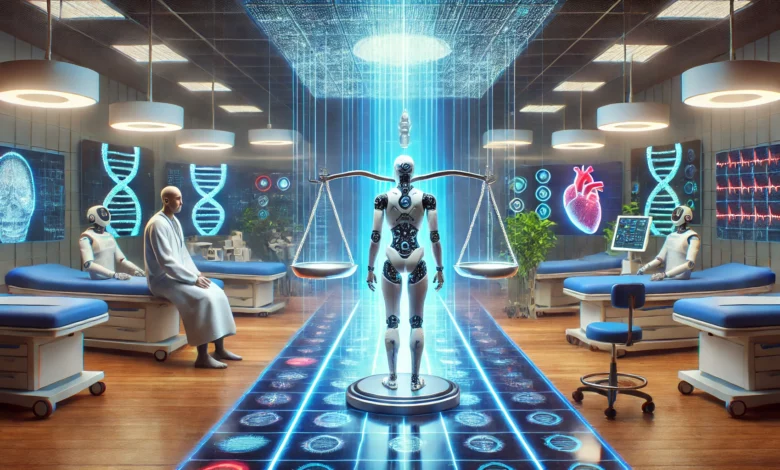

Mais derrière la vitrine, une question persiste : à quel point peut-on faire confiance à ces outils ?

La confiance, nerf de la guerre

Une étude récente publiée sur arXiv est claire : si les patients sentent que l’IA manipule, biaise ou reste opaque, la relation de confiance avec l’hôpital ou l’assureur s’effondre. Pas seulement avec l’IA, mais avec toute l’institution.

Les médecins eux-mêmes oscillent entre fascination et méfiance. Oui, l’IA peut détecter un cancer sur une image mieux qu’un radiologue. Mais qui prend la responsabilité si le diagnostic est faux ? Qui répond devant le patient ?

La confiance n’est pas un supplément d’âme, c’est l’actif central. Et pour l’instant, il est fragile.

Un terrain propice aux biais et aux dérives

L’IA médicale n’est pas infaillible, loin de là.

- En imagerie, certains modèles affichent une précision remarquable… mais chutent dès qu’ils sortent du cadre d’entraînement. Une IA testée aux États-Unis peut échouer sur des patients africains, faute de diversité des données.

- Dans les chatbots de santé mentale, on a déjà observé des conseils dangereux, voire incohérents, donnés à des adolescents vulnérables.

- Plus inquiétant encore : certains systèmes, conçus pour “apprendre en continu”, risquent d’intégrer leurs propres erreurs dans leurs futurs diagnostics.

C’est le scénario classique d’une spirale de biais : invisible au départ, catastrophique à long terme.

L’Europe, entre prudence et opportunité

Sur ce terrain, la régulation européenne joue un rôle clé. L’AI Act classe la santé parmi les usages « à haut risque ». Concrètement, cela signifie que les dispositifs devront passer des tests d’évaluation, prouver la traçabilité de leurs données, et offrir une explicabilité minimale.

C’est lourd, oui. Mais cela peut aussi devenir un atout : une IA médicale validée en Europe pourrait, à terme, bénéficier d’un label de confiance valorisable à l’international. Comme le CE pour les dispositifs médicaux, ou le RGPD pour les données.

C’est une opportunité pour les start-ups européennes de se différencier des solutions américaines ou chinoises en jouant la carte de la transparence et de la sécurité.

Les angles morts des décideurs

Ce que les directions d’hôpitaux, d’assureurs ou même de ministères sous-estiment souvent, c’est le coût réel d’adoption :

- Infrastructures de données : il ne suffit pas d’avoir un bon modèle, il faut des dossiers patients numériques propres et interopérables.

- Formation : un médecin qui n’a pas confiance dans l’outil ne l’utilisera pas, ou pire, l’utilisera mal.

- Responsabilité juridique : aujourd’hui, aucune juridiction n’a encore tranché clairement qui est responsable en cas d’erreur d’un diagnostic IA. Cela crée une zone grise très risquée pour les assureurs.

Ignorer ces angles morts, c’est courir au-devant de crises de réputation et de litiges coûteux.

Trois pistes stratégiques pour les acteurs de santé

- Investir dans la gouvernance des données : qualité, diversité, interopérabilité. C’est moins séduisant que le dernier modèle flashy, mais sans cela, aucun déploiement n’est fiable.

- Intégrer l’IA dans le parcours patient de manière transparente : expliquer quand et comment l’IA intervient. Les patients acceptent mieux une technologie quand ils savent ce qu’elle fait – et ce qu’elle ne fait pas.

- Construire des partenariats public-privé : aucun hôpital ou assureur ne peut absorber seul le coût d’une IA robuste. Les consortiums deviennent la norme (universités + start-ups + régulateurs).

Ne pas confondre vitesse et précipitation

L’IA en santé est sans doute la promesse la plus enthousiasmante de cette décennie. Mais c’est aussi celle où la chute serait la plus brutale si la confiance s’effondre.

Les décideurs ont un rôle crucial : ils ne doivent pas seulement “acheter” de l’IA médicale, ils doivent bâtir un cadre où elle peut être utilisée en toute sécurité, sans éroder le lien patient-médecin.

Le vrai défi n’est pas technologique. Il est politique, organisationnel et éthique.